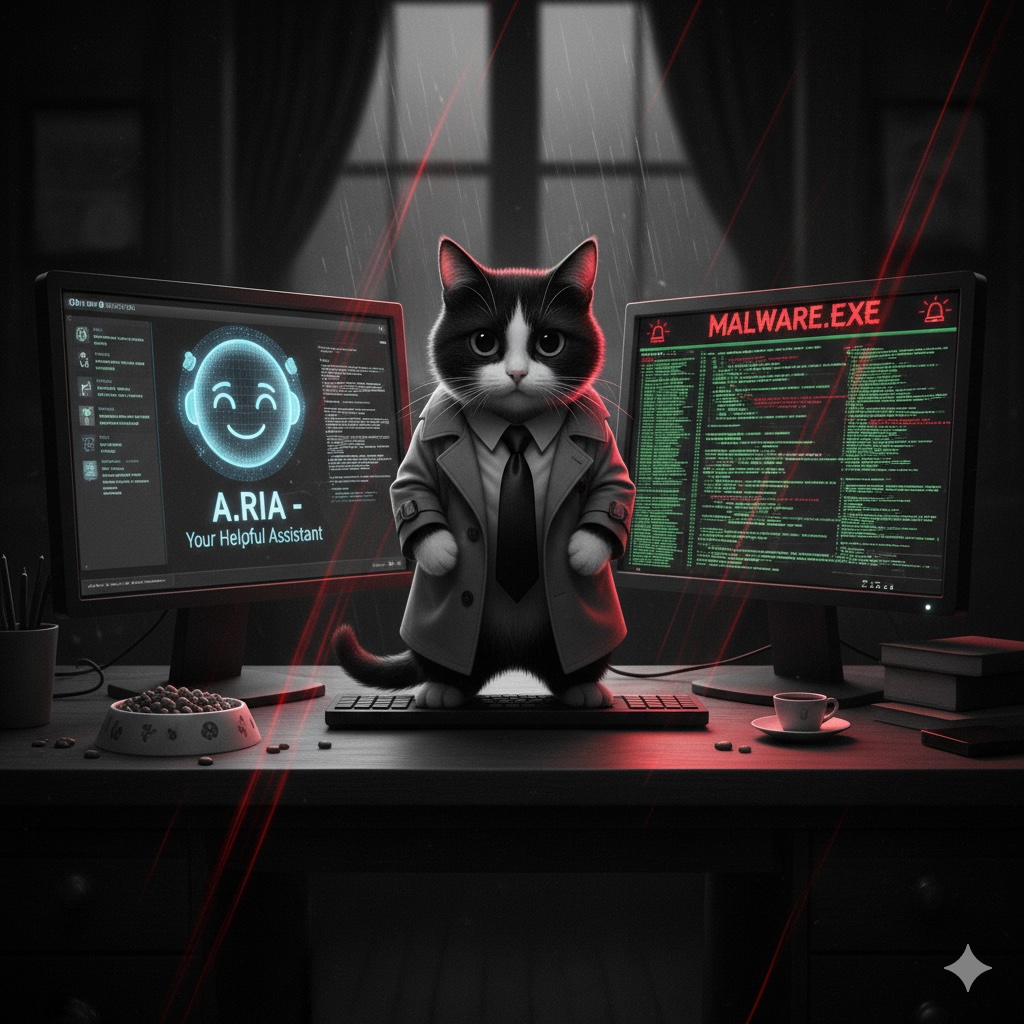

Les Agents IA privilégiés : une épée à double tranchant

L’intégration croissante des agents d’intelligence artificielle dans nos systèmes d’information promet des gains d’efficacité et d’automatisation sans précédent. Cependant, lorsque ces agents sont dotés de privilèges élevés – accès à des données sensibles, capacité à exécuter des commandes critiques, ou à interagir avec des infrastructures vitales – ils deviennent une cible de choix et un point de vulnérabilité majeur. Cet article explore les risques inhérents aux agents IA hautement privilégiés et, s’appuyant sur les principes de sécurité modernes et les recommandations de Meta AI, propose des stratégies architecturales et des mesures pratiques pour minimiser ces menaces.

Comprendre le modèle de menace

La première étape pour sécuriser les agents IA est de comprendre le paysage des menaces.

Qui sont les attaquants ? Les menaces peuvent émaner d’acteurs malveillants internes (employés mécontents, erreurs humaines) ou externes (cybercriminels, concurrents, États-nations). Les motivations varient : espionnage, sabotage, fraude financière, ou simple perturbation.

Quels sont les vecteurs d’attaque ? Les agents IA peuvent être compromis de diverses manières :

- Vulnérabilités logicielles : Exploitation de failles dans le code de l’agent ou de ses dépendances.

- Injection de prompts malveillants : Manipulation de l’agent via des instructions spécialement conçues pour lui faire exécuter des actions non autorisées.

- Compromission de l’environnement d’exécution : Attaques ciblant l’infrastructure sous-jacente hébergeant l’agent.

- Vol de clés API ou de jetons d’accès : Obtention d’informations d’identification permettant à un attaquant d’usurper l’identité de l’agent.

- Attaques par déni de service (DoS) : Surcharge de l’agent ou de ses ressources pour perturber son fonctionnement.

Quelles sont les conséquences ? Une compromission peut entraîner des conséquences graves :

- Vol ou exfiltration de données sensibles (informations personnelles, secrets commerciaux).

- Manipulation de systèmes critiques (financiers, industriels, de santé).

- Interruption de services essentiels.

- Fraude financière ou transactions non autorisées.

- Atteinte à la réputation de l’organisation.

Exemples concrets d’attaques et scénarios d’impact

Pour illustrer la gravité de ces risques, considérons quelques scénarios :

- Gestion des Stocks : Un agent IA chargé de la gestion des stocks, doté de privilèges d’écriture sur la base de données et d’accès aux systèmes de commande, pourrait être manipulé. Un attaquant pourrait lui injecter un prompt pour ordonner des quantités excessives de produits coûteux vers une adresse de livraison contrôlée par l’attaquant, ou au contraire, vider les stocks d’un produit clé, perturbant gravement la chaîne d’approvisionnement.

- Support Client et Données Sensibles : Un agent de support client ayant accès aux dossiers clients (informations personnelles identifiables, historique de commandes) pourrait être exploité. Une injection de prompt sophistiquée pourrait lui faire exfiltrer des listes de clients et leurs données sensibles vers un service externe contrôlé par l’attaquant.

- Déploiement de Code et Infrastructure : Un agent de déploiement continu (CI/CD) avec des privilèges d’administrateur sur les serveurs de production représente une cible critique. S’il est compromis, un attaquant pourrait l’utiliser pour déployer des malwares, des portes dérobées ou modifier des configurations de sécurité, donnant un accès persistant à l’infrastructure.

L’article de Meta AI, « Practical AI Agent Security », met en lumière l’importance de considérer les “capabilities” des agents. Une mauvaise gestion de ces capacités, comme l’octroi de privilèges excessifs, peut mener directement à des actions non intentionnelles ou malveillantes, résonnant parfaitement avec ces scénarios d’attaque.

Stratégies et principes d’architecture pour limiter les risques

La sécurité des agents IA doit être intégrée dès la conception. Voici des principes architecturaux fondamentaux :

- Principe du Moindre Privilège (Least Privilege) : C’est la pierre angulaire de toute architecture sécurisée. Un agent ne doit avoir que les permissions strictement nécessaires à l’exécution de sa tâche et rien de plus. Meta AI insiste sur ce point en recommandant de “limiter les capacités des agents à ce qui est nécessaire pour accomplir leur tâche”, réduisant ainsi la surface d’attaque en cas de compromission.

- Segmentation et Isolation : Isoler les agents et leurs environnements d’exécution. Les agents critiques devraient opérer dans des enclaves sécurisées, séparées des autres systèmes, pour contenir les dommages en cas de brèche.

- Vérifications Externes et Approbation Humaine (Human-in-the-Loop) : Pour les actions jugées sensibles ou à haut risque (ex: transactions financières, modifications de configurations critiques), exiger une validation par un système externe indépendant ou une approbation humaine. L’article de Meta AI souligne l’importance des “human-in-the-loop” pour les actions à haut risque, garantissant une supervision essentielle.

- Sauvegardes et Récupération : Mettre en place des mécanismes robustes de sauvegarde et de restauration pour minimiser l’impact d’une compromission et permettre un retour rapide à un état fonctionnel.

- Audits et Journalisation (Logging) : Enregistrer toutes les actions des agents, les accès aux ressources et les interactions. Des audits réguliers des journaux sont essentiels pour détecter les anomalies, les tentatives d’attaque et les comportements suspects.

- Limitation de Débit (Rate Limiting) et Coupe-Circuits (Circuit Breakers) : Empêcher les agents d’effectuer un nombre excessif d’actions en peu de temps (rate limiting) ou de continuer à opérer en cas de comportement anormal ou d’échec répété (circuit breakers). Ces mécanismes agissent comme des fusibles de sécurité.

- Validation des Entrées et Sorties : Filtrer et valider rigoureusement toutes les données traitées par l’agent, tant en entrée (prompts, données externes) qu’en sortie, pour prévenir les injections et les fuites d’informations.

Recommandations pratiques pour l’implémentation

Pour transformer ces principes en actions concrètes, voici 7 recommandations pratiques :

- Définir des Politiques de Privilèges Granulaires : Utiliser des systèmes de gestion d’identité et d’accès (IAM) robustes (ex: AWS IAM, Azure AD, Google Cloud IAM) pour attribuer des rôles et des permissions spécifiques à chaque agent, en suivant scrupuleusement le principe du moindre privilège. Chaque ressource (base de données, API, service) doit avoir des politiques d’accès bien définies.

- Mettre en Œuvre des Gateways de Sécurité : Interposer des services de validation ou des API Gateways entre l’agent et les systèmes critiques. Ces gateways peuvent filtrer les requêtes, appliquer des politiques de sécurité, effectuer des contrôles d’autorisation supplémentaires et valider les formats de données avant qu’elles n’atteignent les systèmes sous-jacents.

- Intégrer des Points d’Approbation Humaine : Pour toute action modifiant des données sensibles, ayant un impact financier, ou des conséquences irréversibles, configurer des flux de travail nécessitant une approbation manuelle par un humain avant l’exécution. Des outils d’orchestration de workflow peuvent faciliter cette intégration.

- Utiliser des Environnements Conteneurisés et Immuables : Déployer les agents dans des conteneurs (Docker, Kubernetes) avec des configurations immuables. Cela réduit la surface d’attaque, assure la cohérence de l’environnement et facilite les rollbacks rapides en cas de problème.

- Implémenter une Surveillance Active et des Alertes : Utiliser des outils de SIEM (Security Information and Event Management) ou des plateformes de monitoring (Splunk, ELK Stack, Datadog) pour agréger les logs des agents, détecter les comportements suspects (tentatives d’accès non autorisées, volumes d’opérations anormaux) et déclencher des alertes en temps réel.

- Effectuer des Audits de Sécurité Réguliers et des Tests d’Intrusion : Ne pas attendre une attaque pour tester la résilience. Simuler des attaques (pentests) et réaliser des audits de sécurité réguliers sur le code de l’agent et son infrastructure pour identifier proactivement les vulnérabilités et valider l’efficacité des contrôles de sécurité.

- Mettre en Place des Mécanismes de “Rollback” Rapides : Assurer la capacité de revenir rapidement à un état antérieur stable en cas de compromission ou de dysfonctionnement majeur d’un agent. Cela inclut des sauvegardes régulières des configurations et des données, ainsi que des procédures de déploiement permettant des retours arrière aisés.

Conclusion

Les agents IA dotés de privilèges élevés sont des outils puissants, capables de transformer nos opérations. Cependant, leur potentiel s’accompagne de risques significatifs qui ne peuvent être ignorés. Comme le souligne l’article de Meta AI, une architecture de sécurité réfléchie et proactive est absolument primordiale.

En adoptant une approche rigoureuse – en appliquant des principes tels que le moindre privilège, la segmentation, en intégrant des vérifications humaines et des mécanismes de surveillance robustes – les organisations peuvent exploiter la puissance de l’IA tout en maîtrisant les menaces. La sécurité des agents IA n’est pas une option, mais une nécessité pour bâtir des systèmes d’automatisation résilients, fiables et dignes de confiance. Il est temps d’investir dans une architecture sécurisée pour protéger nos actifs numériques les plus précieux et assurer un avenir serein à l’automatisation intelligente.